Что такое индексация сайта

Содержание:

- Что такое сканирование и индексация?

- Как управлять индексированием?

- Все или отдельные страницы закрыты от индексации

- Как добавлять на индексацию в Гугле и Яндексе, и прочих ПС

- Пояснение терминов «индексация сайта» и «поисковый индекс»

- Что такое индексация сайта?

- Основания для перерасчета

- Как управлять поисковым роботом

- Индексация сайта в поиске

- Как узнать, какие страницы проиндексированы поисковой системой?

- Способы проверки индексации сайта

- Как узнать какие страницы дают трафик, а какие пользователи игнорируют?

- Как проверить индексацию

- Что такое индексация обратных ссылок

- Методы по ускорению индексирования сайта в поисковиках

Что такое сканирование и индексация?

Сканирование страниц сайта — это процесс, когда поисковая система отправляет свои специальные программы (мы знаем их как поисковых роботов, краулеров, спайдеров, пауков) для сбора данных с новых и измененных страниц сайтов.

Индексация страниц сайта — это сканирование, считывание данных и добавление их в индекс (каталог) поисковыми роботами. Поисковик использует полученную информацию, чтобы узнать, о чем же ваш сайт и что находится на его страницах. После этого он может определить ключевые слова для каждой просканированной страницы и сохранить их копии в поисковом индексе. Для каждой страницы он хранит URL и информацию о контенте.

В результате, когда пользователи вводят поисковый запрос в интернете, поисковик быстро просматривает свой список просканированных сайтов и показывает только релевантные страницы в выдаче. Как библиотекарь, который ищет нужные вам книги в каталоге — по алфавиту, тематике и точному названию.

Индексация сайтов в разных поисковых системах отличается парой важных нюансов. Давайте разбираться, в чем же разница.

Как управлять индексированием?

Как стимулировать роботов внести страницы в индекс:

1. Открыть закрытые для индексирования страницы.

2. Проследить, чтобы страницы просканировались, добавляя ссылки для сканирования в очередь с помощью вебмастера. Также можно использовать «ловцов ботов» — программы, основная задача которых предоставлять поисковым роботам ссылки на важные страницы сайта.

3. Размещать релевантный контент, метатеги, оптимизировать изображения, следить, чтобы рекламные блоки занимали максимум 30% первого экрана сайта.

Как ограничить доступ роботов к индексированию контента:

1. Добавить специальный метатег в верхней части HTML-страниц: <meta name=»robots» content=»noindex» />.

2. Добавить специальный HTTP-заголовок: X-Robots-Tag: noindex.

Все или отдельные страницы закрыты от индексации

Почему сайт не индексируется, если вы сообщили о нем поисковым системам? Возможно, дело в том, что в настройках сайта запрещена индексация.

Например, многие вебмастера при наполнении страниц контентом делают их недоступными для поисковых роботов, чтобы те не забрали недоделанные материалы. Чаще всего для этого используют файл robots.txt, в котором и задаются параметры индексации.

Откройте файл robots.txt. Посмотрите, есть ли в нем такая запись:

User-agent: * Disallow:

Если нашли ее, то удалите — это запрет на индексацию всего сайта. Могут быть и другие ограничения. Чтобы разобраться с настройками индексации, изучите статью о том, что такое robots.txt и как его настроить.

Если в robots.txt все в порядке, проверьте файл .htaccess. Ищите в нем подобный фрагмент:

SetEnvIfNoCase User-Agent "^Googlebot" search_bot SetEnvIfNoCase User-Agent "^Yandex" search_bot SetEnvIfNoCase User-Agent "^Yahoo" search_bot SetEnvIfNoCase User-Agent "^Aport" search_bot SetEnvIfNoCase User-Agent "^msnbot" search_bot SetEnvIfNoCase User-Agent "^spider" search_bot SetEnvIfNoCase User-Agent "^Robot" search_bot SetEnvIfNoCase User-Agent "^php" search_bot SetEnvIfNoCase User-Agent "^Mail" search_bot SetEnvIfNoCase User-Agent "^bot" search_bot SetEnvIfNoCase User-Agent "^igdeSpyder" search_bot SetEnvIfNoCase User-Agent "^Snapbot" search_bot SetEnvIfNoCase User-Agent "^WordPress" search_bot SetEnvIfNoCase User-Agent "^BlogPulseLive" search_bot SetEnvIfNoCase User-Agent "^Parser" search_bot

Это полный запрет на индексацию сайта. Удалите эти строки, если Яндекс или Гугл не индексирует страницы.

Запрет на индексацию также может быть прописан в метатегах. Изучите раздел <head> на главной странице. Ищите такую запись:

<meta name=«robots» content=«no index, nofollow»>

Если такая строчка есть, удалите ее.

Отдельные настройки приватности есть у CMS и конструкторов сайтов. Например, сайт на WordPress закрывается от поисковых роботов с помощью опции «Видимость для поисковых систем». Если поставить галочку «Попросить поисковые системы не индексировать сайт», то, скорее всего, он не появится в выдаче. Однако нет гарантии, что этот запрос будет учитываться, в отличие от прямого запрета на индексацию в robots.txt или метатегах.

Как добавлять на индексацию в Гугле и Яндексе, и прочих ПС

Сейчас мы займемся рассмотрением вопроса добавления нового ресурса во всевозможные поисковики. Разберем наиболее популярные системы.

Яндекс добавить сайт на индексацию

Для добавления проекта на Яндекс портал поисковую систему необходимо перейти к форме добавления, в простонародье аддурилка. Располагается по адресу: http://webmaster.yandex.ru/addurl.xml

В открывшейся форме следует указать УРЛ адрес главной страницы добавляемого сайта и ввести капчу. После нажатия кнопки «Добавить» произойдет следующее:

-

Выскочит сообщение «ваш сайт добавлен» — это значит, что все в порядке, ресурс поставлен в очередь на индексацию в яндексе;

-

Появится сообщение «Ваш хостинг не отвечает» — это означает, что проблема с сервером, а точнее он прилег отдохнуть в тот момент;

-

Выскочила надпись «указанный URL запрещен к индексации» — можно начинать паниковать. На домен были наложены санкции, в результате чего он оказался забаненым. В таком случае, придется списываться с техподдержкой Яндекса и пытаться выяснять, как выходить из сложившегося положения.

Отправить сайт на индексацию Google

Добавление сайта в Гугл поисковую систему проходит точно так же как и в Yandex. Google имеет свою аддурилку, что находится по адресу: https://www.google.com/webmasters/tools/submit-url.

От капчи Вам и тут никуда не деться, правда, имеется пара отличий. В яндексе не обязательно иметь свой аккаунт, чтобы добавить url, а вот в Гугле Вы должны быть залогинены в свою учетную запись. И второй момент – это скорость: индексация в гугле происходит быстрее.

Индексация сайта в Рамблере

Хоть Рамблер информационно-поисковая система уже не представляет собой того гиганта поиска как раньше, но небольшой трафик с него все же идет, так зачем им пренебрегать. Скорость индексации в Рамблере гораздо ниже, чем рассмотренных выше ПС. Так что не удивляйтесь, если Вашего проекта долгое время не будет в индексе этого поисковика.

Поскольку данная система уже давно перестала развивать свой поиск, то и от аддурилки проку никакого. Так куда стучаться, чтобы произошла индексация сайта в rambler? Если Вы уже добавились в Яндекс, то стучаться больше никуда не нужно, так как в Рамблер интегрирована поисковая база Yandex.

Индексация в mail.ru

Поисковая система майл ру также имеет в своем арсенале кабинет вебмастера, где и можно добавить ресурс в систему. Другой способ добавления вебсайта на индексацию mail – это напрямую зайти по адресу: http://go.mail.ru/addurl.

Система майл стала активно развивать свой поиск и различные сервисы, в том числе и инструменты для вебмастеров, поэтому чтобы оставить заявку на индексацию сайта в mail ru следует завести свой аккаунт.

Индексация в Nigma

Нигма интеллектуальная поисковая система разработанная в России пытается всунуться и отхватить долю Рунета. В данный момент она смогла отвоевать порядка 3 млн запросов в сутки. Делаем вывод, что отмахиваться от данного поисковика не стоит, а потому вот ссылка, по которой можно добавить ресурс на индексацию в Нигму: http://www.nigma.ru/index_menu.php?menu_element=add_site.

Индексация сайта Yahoo

Поисковая система yahoo принадлежит к тем поисковикам, что первыми стали покорять просторы Интернета. Она знакома пожалуй всем и каждому, кто мало мальськи связан с глобальной сетью. Добавить проект на индексацию в Яхоо: http://search.yahoo.com/info/submit.html.

Индексация сайта в Bing

Бинг поисковая система является детищем Майкрософта и пришла на замену Live Search. По заявлениям представителей Microsoft Bing гораздо эффективнее предшественника и он готов составить конкуренцию Гугл. Так ли это покажет время. Но трафик с данного поисковика есть, а значит добавлять сайт на индексирование необходимо: http://www.bing.com/toolbox/submit-site-url.

Пояснение терминов «индексация сайта» и «поисковый индекс»

Под индексацией веб-ресурса подразумевают посещение ботами его интернет-страниц, анализ содержащегося в них контента и его добавление в базу данных. Это делается для того, чтобы потом пользователи могли находить информацию на ресурсе по ключевым запросам в поисковых системах.

Проще говоря, юзер заходит в поисковик, вводит в строке поиска нужный ему запрос и в ответ получает список из множества веб-страниц, проиндексированных поисковыми роботами.

Индексация является обязательной процедурой в работе поисковых систем. Для этого создается специальная специализированная база данных, посредством которой и формируются результаты выдачи.

Поисковый индекс любого сайта зависит непосредственно от его контента, внешних и внутренних ссылок, наличия изображений, графиков и прочих материалов. Вводя в поисковой строке запрос, интернет-пользователь обращается к индексу. Затем из него на основании данных осуществляется ранжирование результатов поиска, список страниц, которые выстраиваются по мере уменьшения релевантности запросу.

Представьте, что Всемирная Сеть – это большая библиотека. В ней обязательно должен быть специальный каталог, который делает поиск необходимых материалов гораздо проще. Всем книгам, которые находятся в библиотеке, принадлежит свой шифр. Все шифры объединены темами, разделами и прочими параметрами.

Когда человек приходит в библиотеку и просит книгу на определенную тематику (делает запрос), библиотекарь идет к нужному разделу, достает все книги, соответствующие ему, и подбирает для читателя самую подходящую.

По аналогичному принципу работают и поисковики: пользователь делает запрос, поисковая машина достает все соответствующие страницы и выдает наиболее релевантные.

На заметку. Под занавес прошлого века индексация проходила именно по принципу каталогизации – боты отыскивали на ресурсах ключевые слова, из которых и состояла база данных. В наши дни роботы, помимо ключевиков, учитывают множество других параметров контента, в числе которых уникальность, информативность, грамотность и многое другое. Именно на этом и основывается современная индексация.

С каждым годом поисковые алгоритмы становятся все совершеннее, база данных все больше наполняется дополнительной информацией, при этом поиск для пользователей становится куда легче и более релевантнее.

Что такое индексация сайта?

Индексацией сайта называют процесс добавления информации о содержимом (контенте) сайта в базу данных поисковиков. Именно индекс и является базой данных поисковых систем. Для того чтобы сайт был проиндексирован и появился в поисковой выдаче, на него должен зайти специальный поисковый бот. Весь ресурс, страница за страницей, исследуется ботом по определенному алгоритму. В результате находя и индексируя ссылки, изображения, статьи и т. д. При этом в поисковой выдаче выше в перечне будут находиться те сайты, авторитет которых выше по сравнению с остальными.

Выделяют 2 варианта индексации сайта ПС:

- Самостоятельное определение поисковым роботом свежих страниц либо созданного ресурса — данный способ хорош при наличии активных ссылок с других, уже проиндексированных сайтов, на ваш. В ином случае ждать поискового робота можно бесконечно долго;

- Пнесение URL на сайт в предназначенной для этого форме поисковика ручным способом — этот вариант позволяет новому сайту «встать в очередь» на индексацию, которая займет довольно продолжительное время. Способ простой, бесплатный и требует внесения адреса лишь главной страницы ресурса. Данную процедуру можно выполнить через панель вебмастера Яндекса и Гугла.

Основания для перерасчета

Несмотря на то, что в качестве одной их мер приблизить уровень реального содержания зарплаты в связи с инфляцией законодатель в ст. 134 ТК РФ указывает индексацию, это не значит, что повышение цен служит показателем для перерасчета заработка.

Четко обозначенного механизма, периодичности и порядка проведения процедуры индексации не существует. Принимать решение о необходимости индексации выплат собственники и уполномоченные ими руководить деятельностью предприятий и организаций вправе на свое усмотрение, утвердив данные нормы локальными правовыми актами внутреннего пользования.

За основания проведения индексации можно, но не обязательно принимать соответствующие публикации Росстата. Как показывает практика судебных разбирательств по обращению граждан с исками о защите гарантированных трудовых прав, эти показатели должны расцениваться как повод для увеличения уровня выплат.

Правом работодателя остается, в качестве условия индексации заработной платы, руководствоваться данными увеличения цен:

- по всей стране;

- в регионе местонахождения предприятия, выступающего юридическим лицом или фактической деятельности предпринимателя, использующего труд наемных рабочих;

- ростом прожиточного минимума трудоспособной части населения.

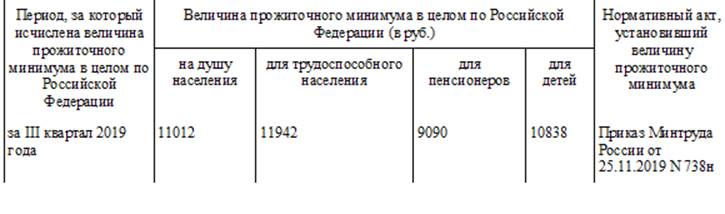

Согласно подготовленной специалистами КонсультантПлюс, величина прожиточного минимума на душу населения на I квартал 2021 года в марте текущего года по стране не установлена. За базовый ориентир принимают прошлогодние показатели III квартала 2019 года:

Как управлять поисковым роботом

Поисковая система скачивает информацию с сайта, учитывая robots.txt и sitemap. И именно там вы можете порекомендовать поисковику, что и как скачивать или не скачивать на вашем сайте.

Файл robots.txt

Это обычный текстовый файл, в котором указаны основные сведения — например, к каким поисковым роботам мы обращаемся (User-agent) и что запрещаем сканировать (Disallow).

Указания в robots.txt помогают поисковым роботам сориентироваться и не тратить свои ресурсы на сканирование маловажных страниц (например, системных файлов, страниц авторизации, содержимого корзины и т. д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

Также в robots.txt стоит обязательно указать адрес карты сайта, чтобы указать поисковым роботам ее местоположение.

Чтобы проверить корректность robots.txt, загрузите его в специальную форму на странице Яндекс.Вебмастер или воспользуйтесь отдельным инструментом в .

Файл Sitemap

Еще один файл, который поможет вам оптимизировать процесс сканирования сайта поисковыми роботами ― это карта сайта (Sitemap). В ней указывают, как организован контент на сайте, какие страницы подлежат индексации и как часто информация на них обновляется.

Если на вашем сайте несколько страниц, поисковик наверняка обнаружит их сам. Но когда у сайта миллионы страниц, ему приходится выбирать, какие из них сканировать и как часто. И тогда карта сайта помогает в их приоритезации среди прочих других факторов.

Также сайты, для которых очень важен мультимедийный или новостной контент, могут улучшить процесс индексации благодаря созданию отдельных карт сайта для каждого типа контента. Отдельные карты для видео также могут сообщить поисковикам о продолжительности видеоряда, типе файла и условиях лицензирования. Карты для изображений ― что изображено, какой тип файла и т. д. Для новостей ― дату публикации. название статьи и издания.

Чтобы ни одна важная страница вашего сайта не осталась без внимания поискового робота, в игру вступают навигация в меню, «хлебные крошки», внутренняя перелинковка. Но если у вас есть страница, на которую не ведут ни внешние, ни внутренние ссылки, то обнаружить ее поможет именно карта сайта.

А еще в Sitemap можно указать:

- частоту обновления конкретной страницы — тегом <changefreq>;

- каноническую версию страницы ― атрибутом rel=canonical;

- версии страниц на других языках ― атрибутом hreflang.

Карта сайта также здорово помогает разобраться, почему возникают сложности при индексации вашего сайта. Например, если сайт очень большой, то там создается много карт сайта с разбивкой по категориям или типам страниц. И тогда в консоли легче понять, какие именно страницы не индексируются и дальше разбираться уже с ними.

Проверить правильность файла Sitemap можно на странице Яндекс.Вебмастер, а также в Google Search Console вашего сайта в разделе «Файлы Sitemap».

Итак, ваш сайт отправлен на индексацию, robots.txt и sitemap проверены, пора узнать, как прошло индексирование сайта и что поисковая система нашла на ресурсе.

Индексация сайта в поиске

Теперь, когда мы рассказали, что такое индексация, почему она так важна и как её проверить, приступим к практике.

Как ускорить индексацию?

Мы писали выше, что управлять индексацией, что бы кто не говорил, вы не можете. Но повлиять на процесс или даже ускорить возможно.

Советы по ускорению индексации

- Обязательно добавьте сайт во все сервисы Яндекса и Google, особенно в Яндекс Вебмастер и Google Search Console.

- Создайте sitemap.xml, поместите карту в корень сайта и постоянно обновляйте.

- Следите за robots.txt и исключайте ненужные страницы (об этом ниже).

- Выберите надёжный и быстрый хостинг, чтобы робот мог беспрепятственно индексировать содержимое сайта.

- Используйте инструменты Яндекс Вебмастера (Индексирование → Переобход страниц) и Google Search Console (Проверка URL → Запросить индексирование). Способ идеально подходит для работы с отдельными страницами.

- Если ваша CMS любит создавать дубли (например, Битрикс), то используйте атрибут rel=canonical.

- Автоматизируйте создание новых ссылок со старых страниц. Как вариант, можно сделать блок на главной с новыми товарами или статьями.

- Ведите соцсети и анонсируйте новые товары, услуги, страницы. Замечено, что ссылки с соцсетей могут ускорить процесс.

- Создавайте качественный контент на каждой странице. Под качественным контентом мы понимаем актуальную, релевантную и уникальную информацию для пользователей.

- Работайте над структурой сайта и делайте её удобной и понятной пользователю. Помните о правиле 3 кликов: это оптимальное количество действий для пользователя.

- Проверяйте периодически сайт на вирусы и санкции поисковых систем. В Яндекс Вебмастере раздел Диагностика → Безопасность и нарушения, в Google Search Console — раздел Проблемы безопасности и меры, принятые вручную.

- Улучшайте свой ссылочный профиль и пишите анонсы на других сайтах (в рамках правил поисковых систем).

- Используйте родные браузеры (Chrome, Яндекс Браузер) и заходите на новые страницы с них.

Как запретить индексацию?

Выше мы рассмотрели основные способы, как ускорить индексацию, и рассказали, что такое краулинговый бюджет и почему он ограничен для каждого сайта. Поэтому чтобы его не тратить зря, советуем закрывать от индексации служебные и технические страницы, кабинеты пользователей и конфиденциальную информацию, а также страницы в разработке и дубли.

3 основных способа запретить индексацию:

- Директива Disallow в файле robots. Мы писали, что такой запрет может не сработать в отдельных случаях. Тем не менее это основной способ запрета индексации.

- В коде страницы указать метатег robots с директивой noindex (для текста) и/или nofollow (для ссылок). Хорошо подходит для запрета индексации отдельных страниц.

- Настроить HTTP-заголовок X-Robots-Tag с директивой noindex и/или nofollow. Лучше всего подходит для закрытия индексации не HTML-файлов (PDF, изображения, видео и другие).

Используйте все наши советы по улучшению индексации на полную мощь.

Максимальное внимание уделите улучшению структуры и навигации и обновлению карты сайта.

Структура сайта должна быть проста и понятна, охватывать весь спектр ключевых запросов, а каждая страница сайта в идеале должна быть доступна в 3–4 клика

Для этого используйте дополнительные блоки на главной странице и в разделах.

Хорошо работает облако тегов: с помощью него часто получается продвигать категории, улучшать навигацию и полно охватывать семантику.

Для многостраничных сайтов действительно важно постоянно обновлять sitemap.xml

Зачастую в таких случаях карту делят на несколько частей, чтобы охватить весь список страниц.

Настройте маски (автоматические шаблоны) метатегов для новых страниц в категориях и каталогах.

Скорее всего, вам не обойтись без команды профессионалов, которые смогут обеспечить техподдержку, производство контента и SEO-продвижение.

Как узнать, какие страницы проиндексированы поисковой системой?

Через оператор site: в поисковом запросе

Самый простой способ узнать примерное количество страниц в поисковой выдаче – набрать в поисковой строке адрес сайта, используя оператор site:адресвашегосайта.ру. Адрес сайта лучше указывать без протокола http/https, без использования www.

И аналогично в Google:

Количество проиндексированных страниц в Яндекс и Google должно примерно совпадать. Если где-то наблюдается явный перекос, возможно, сайт индексируется неправильно. Если у вас такая проблема — пишите нам, обязательно разберемся, в чем именно проблема.

Также можно проверить индексацию одной определенной страницы. Для этого используется оператор url:адресстраницы

Если в результатах выдачи пусто — страница отсутствует в индексе.

Через вебмастера Яндекс и Google.

Информация из первых рук. Только в вебмастерах можно определить точное количество просканированных страниц, страниц в поиске, исключенных страниц из выдачи.

В Яндекс.Вебмастере этому посвящён целый раздел – «Индексирование».

Узнать общее количество страниц в индексе можно в подразделе — «Страницы в поиске». Наводим на графике мышкой на текущее число – там мы увидим общее число проиндексированных страниц, количество проиндексированных страниц из каждого подраздела сайта.

В Google Search Console переходим в раздел «Индекс» — «Покрытие».

Способы проверки индексации сайта

Предлагаем вашему вниманию 4 самых распространенных и простых способа, позволяющие проверить, какие страницы есть в индексе, а какие – нет.

1. Через панель вебмастера

Этим методом владельцы веб-ресурсов проверяют их наличие в поиске чаще всего.

Яндекс

- Авторизуйтесь в Яндекс.Вебмастер.

- Перейдите в меню «Индексирование сайта».

- Под ним найдите строку «Страницы в поиске».

Можно пойти и по другому пути:

- Выберите «Индексирование сайта».

- Дальше перейдите в «История».

- Затем кликните на вкладку «Страницы в поиске».

И первым, и вторым способом вы сможете изучить динамику роста или спада числа страниц в поисковой системе.

- Зайдите в панель управления сервиса .

- Кликните на вкладку Search Console.

- Перейдите в «Индекс Google».

- Нажмите на опцию «Статус индексирования».

2. Через операторов поисковых систем

Они помогают уточнить результаты поиска. Так, применение оператора «site» позволяет увидеть приблизительное число страниц, которые уже находятся в индексе. Чтобы проверить этот параметр, в строке поиска Яндекс либо Google укажите: «site:адрес_вашего_сайта».

Важно! Если результаты в Google и Яндекс сильно разнятся между собой, то значит ваш сайт имеет какие-то проблемы со структурой сайта, мусорными страницы, индексацией или на него наложены санкции. Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени

Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа»

Для поиска вы также можете использовать дополнительные инструменты, например, чтобы узнать, как изменялась индексация страниц за определенный период времени. Для этого под поисковой строкой нажмите на вкладку «Инструменты поиска» и выберите период, к примеру, «За 24 часа».

3. Посредством плагинов и расширений

Используя специальные программы, проверка индексации веб-ресурса произойдет автоматически. Это можно сделать с помощью плагинов и расширений, еще известных как букмарклеты. Они представляют собой javascript-программы, которые сохраняются в браузере в виде стандартных закладок.

Преимущество плагинов и расширений в том, что вебмастеру нет необходимости каждый раз по новой заходить в поисковик и вводить там адреса сайтов, операторы и прочее. Скрипты произведут все в автоматическом режиме.

Самым популярным плагином, применяемым в этих целях, является RDS bar, который можно скачать в магазине приложений любого браузера.

Стоит отметить, что в Mozilla Firefox у плагина куда больше возможностей, чем в других браузерах. RDS bar предоставляет информацию относительно и всего веб-сайта, и его отдельных страниц

На заметку. Есть платные и бесплатные плагины. И самый большой минус бесплатных плагинов в том, что в них регулярно нужно вводить капчу.

Нельзя оставить без внимания и букмарклет «Проверка индексации». Чтобы включить программу, просто перетяните ссылку на панель браузера, а затем запустите свой портал и нажмите на закладку расширения. Так вы откроете новую вкладку с Яндекс или Google, где изучите нужную информацию касательно индексации определенных страниц.

4. С помощью специальных сервисов

Я в основном пользуюсь сторонними сервисами, потому что в них наглядно видно какие страницы в индексе, а какие там отсутствуют.

Бесплатный сервис

https://serphunt.ru/indexing/ — есть проверка, как по Яндекс, так и по Google. Бесплатно можно проверить до 50 страниц в сутки.

Платный сервис

Из платных мне больше всего нравится Topvisor — стоимость 0.024р. за проверку одной страницы.

Вы загружаете в сервис все страницы вашего сайта и он вам покажет, какие находятся в индексе поисковых систем, а какие нет.

Как узнать какие страницы дают трафик, а какие пользователи игнорируют?

Подробный отчет обо всех страницах входа на сайт из поисковой выдачи можно найти в Яндекс.Метрике. Раздел «Отчёты» — «Стандартные отчёты» — «Содержание» — «Страницы входа».

По каждой странице отображается информация о количестве визитов, посетителях, проценте отказов, глубине просмотра и общем времени по выбранной странице. Анализ проведенного времени на сайте и количества отказов станет отличным помощником в улучшении юзабилити сайта. Процент отказов больше 25% говорит нам о том, что со страницей точно не все в порядке, и каждый 4 посетитель уходит с сайта.

Информацию о показах и кликах по каждой странице можно найти в Яндекс.Вебмастере. Раздел «Поисковые запросы» — «Статистика страниц».

Используйте информацию для улучшения сниппета сайта. Большое количество показов без кликов говорит о том, что сниппет страницы не привлекает пользователей, и все клики достаются конкурентам.

Как проверить индексацию

Проверка видимости документов html осуществляется по-разному для Google и Яндекс. Но в целом не представляет собой ничего сложного. Сделать это сможет даже новичок.

Проверка в Яндекс

Система предлагает три основных оператора, позволяющих проверить, сколько html-документов находится в индексе.

Оператор «site:» – показывает абсолютно все страницы ресурса, которые уже попали в базу данных.

Вводится в строку поиска следующим образом: site:znet.ru

Оператор «host:» – позволяет увидеть проиндексированные страницы с доменов и поддоменов в рамках хостинга.

Вводится в строку поиска следующим образом: host:znet.ru

Оператор «url:» – показывает конкретную запрашиваемую страницу.

Вводится в строку поиска следующим образом: url:znet.ru/obo-mne

Проверка индексации этими командами всегда дает точные результаты и является самым простым способом анализа видимости ресурса.

Проверка в Google

ПС Гугл позволяет проверить видимость сайта только по одной команде вида site:znet.ru.

Но у Google есть одна особенность: он по-разному обрабатывает команду с введенными www и без. Яндекс же такого различия не делает и дает абсолютно одинаковые результаты, что с прописанными www, что без них.

Проверка операторами — это самый «дедовский» способ, но я для этих целей пользуюсь плагином для браузера RDS Bar.

Проверка с помощью Webmaster

В сервисах Google Webmaster и Yandex Webmaster также можно посмотреть, сколько страниц находится в базе данных ПС. Для этого нужно быть зарегистрированным в этих системах и внести в них свой сайт. Попасть в них можно по ссылкам:

http://webmaster.yandex.ru/ — для Яндекс.

https://www.google.com/webmasters/ — для Google.

В Яндекс Вебмастере при нажатии на ссылку «Мои сайты» в левом боковом меню появятся все необходимые пункты для проверки не только количества страниц, но и многих других полезных и важных данных, в том числе и истории индексации.

Массовая проверка страниц на индексацию

Если вы ведете файл семантики по моей схеме, то проверить все страницы на индексацию для вас — дело трех минут.

- Заходим в файл распределения

- Выделяем все урлы в столбце URL

- Вкладка «Данные» — «Удалить дубликаты», таким образом останется список всех продвигаемых страниц

- Массово проверяем страницы на индексацию через Comparser. Можно и с помощью браузерного плагина Winka – он умеет работать со списком ссылок в отрыве от Сапы (вызвать меню плагина – проверка списка ссылок).

Сервисы вроде Serphunt

Сейчас я проверяю индексацию в основном здесь: https://serphunt.ru/indexing/, потому что у них можно сразу 50 урлов проверить и причем не только в яндексе, но и в гугле. Мало где можно проверить одновременно в обеих ПС на халяву сразу 50 урлов.

Суть такая — просто вбиваете адреса страниц, и сервис вам выдаёт результаты:

Проверяет не очень быстро — там надо будет подождать минуты 3, но к бесплатному инструменту и претензий немного. Просто в фоновом окне ставьте и занимайтесь своими делами, через несколько минут результаты будут готовы.

Что такое индексация обратных ссылок

Индексация обратных ссылок — процесс добавления их в базу поисковых систем. Когда роботы Яндекса и Гугла обнаруживают новый контент, они сканируют его и через некоторое время страница появляется в выдаче.

Несколько лет назад поисковики индексировали контент гораздо медленнее, чем сейчас. Особенно ярко выраженной проблема была в Яндексе. Вебмастера неделями ждали апдейтов, чтобы новые страницы попали в базу поисковой системы и начали набирать вес.

В 2021 году таких проблем нет — если сайт хорошо оптимизирован по технической части и регулярно публикует контент, новые адреса быстро попадают сначала в быструю выдачу, а затем в основную.

С бэклинками не все так просто — они индексируются гораздо дольше. При покупке ссылок напрямую есть риск остаться ни с чем. К примеру, если на сайте вебмастера проблемы с файлом robots.txt или неправильно настроен тег meta robots, ничего сделать не получится. Придется ждать, пока владелец проекта выйти на связь и разберется с ошибками.

Проблемы с индексацией ссылок на авторитетных сайтах возникают редко. Если контент регулярно обновляется и быстробот добавляет новые страницы в индекс, Google и Яндекс быстро обнаруживают проставленные ссылки и индексируют их.

Скорость появления бэклинков в консолях для вебмастеров зависит от многих факторов, поэтому нельзя однозначно сказать, когда ссылка начнет учитываться поисковиками. При наличии технических проблем у поисковых систем процесс обновления ссылочного профиля может затянуться надолго.

Часто бывает так, что при проверке сторонними сервисами находится гораздо больше бэклинков, чем в Google Search Console и Яндекс.Вебмастер. Это нормальная ситуация, но линки с основных ресурсов должны быть видны во всех источниках.

Факторы, которые влияют на индексацию ссылок

Опытные SEO-специалисты и вебмастера знают главное правило линкбилдинга: «Ссылки с трастовых и релевантных ресурсов на вес золота». Обычно с такими бэклинками не возникают проблемы, они быстро индексируются и приносят профит в виде хороших позиций. Особенно важна скорость индексации обратных ссылок при продвижении новых сайтов.

Что касается появления ссылки в консолях для вебмастеров, то данные могут обновляться с задержкой. Часто бэклинки пропадают из списка, а потом снова появляются. Это естественный процесс, на нём не стоит зацикливаться.

Факторы, влияющие на индексацию ссылок:

- Качество донора. Чем авторитетнее сайт в глазах поисковых систем, тем быстрее индексируются страницы и обратные ссылки. Как же проверить качество и траст донора, читайте в статье.

- Правильность размещения. Неактивные ссылки и URL, ссылающиеся на неосновное зеркало, могут не появиться в консолях для вебмастеров.

- Частота обновления контента. Ссылки с новостных проектов и других ресурсов с непрерывным процессом обновления информации индексируются гораздо быстрее.

- Техническое состояние. Если сайт часто падает, некорректно настроены каноникалы или страницы отдают неправильный код, могут возникнуть проблемы с попаданием линков в базу поисковых систем.

- Стабильность поисковиков. При глобальных обновлениях алгоритмов или масштабных изменениях в Google Search Console или Яндекс.Вебмастер новый контент может индексироваться с задержкой.

Если закупаете ссылки на качественных проектах и придерживаетесь четкого плана по линкбилдингу, проблем с индексацией и учетом бэклинков не будет. Следите за ситуацией, но в разумных пределах. Нет смысла несколько раз в день заходить в консоли для вебмастеров и обновлять страницу с внешними ссылками.

Методы по ускорению индексирования сайта в поисковиках

Как я уже говорил необходимо писать уникальные статьи, иначе не только не проиндексируется, но и весь сайт “упадет” в выдаче

Проверьте контент на уникальность и при необходимости перепишите.

Регулярное обновление

Как писал выше, скорость индексации уменьшается, когда увеличивается интервал опубликованных статей на сайте.

Ссылки с других ресурсов

Обменяйтесь ссылками с другим сайтом или купите на требуемую страницу ссылку с биржи ссылок, но очень важно чтобы они были с хорошо индексируемых сайтов. Лучше всего покупать такие ссылки с авторитетных блогов или сми ресурсов

Тут описана инструкция по отбору качественных доноров в биржах.

Социальные закладки

Один из способов привлечь робота на свой ресурс. Очень много есть программ которые прогоняют по сотням соц. закладок, но лучше добавить вручную в десяток самых значимых. Наиболее популярные:

memori.ru;

bobrdobr.ru;

moemesto.ru;

mister-wong.ru;

links.i.ua;

linkmarker.ru;

zakladok.net.

Социальные сети

Как Вы знаете, в последнее время ссылки из социальных сетей типа ВК, Facebook, Twitter, Google Plus, ОК и т.д. очень важны для поведенческих факторов. Следовательно, создайте себе аккаунт/группу, добавьте небольшой информационный блок и поставьте ссылку для перехода на необходимую страницу с полной версией.

Залогом успешной индексации сайта является правильное перенаправление ссылок внутри своего ресурса.

RSS трансляция

Поисковики очень хорошо индексируют RSS каталоги и опубликование анонсов ваших материалов увеличивает успешность индексации.

Ссылка в Вашем профиле на форуме

Зарегистрируйтесь на тематических форумах касательно своего проекта и пропишите ссылку на свою главную страницу в профиле, и когда будете добавлять комментарий, то автоматически подсоединится Ваша ссылка, а роботы хорошо индексируют мощные, хорошо развитые форумы. А как находить релевантные форумы и как отбирать их по качеству я расписал тут.

Сервис Вопрос-Ответ

Одно из новшеств интернета (например, ответы mail ru), наподобие форумов, где люди задают всевозможные вопросы. Не надо спамить, этого никто не любит, лучше найдите вопрос по тематике, что публикуете и дайте небольшой отрывок из своей статьи, а в качестве продолжения укажите ссылку к полной версии. Таким нехитрым способом Вы получите дополнительное количество посетителей к себе на сайт и дадите возможность роботу проиндексировать эту страницу.

Вес страницы

И последнее, но немало важное – это уменьшение веса страниц. Не нужно «напрягать» бедных роботов копаться в Вашем «мусорнике» из кодов и скриптов

Уменьшение веса приведет к ускорению продвижения робота по сайту.