Парсинг

Содержание:

- Где найти парсер?

- Что такое парсер и как он работает

- «Как защититься (от парсинга) по уму? Да никак, всё равно пролезем»

- Выбираем модель

- Parsing

- Достоинства парсинга

- Определение синтаксического парсинга

- Используйте другие возможности сервисов парсинга

- Начнём с простого

- Автоматически следовать редиректам с cURL

- Парсеры поисковых систем#

- Основы веб-парсинга

- Что такое парсинг

- Отрендерите JS через Headless Browsers

- Программа: извлечение данных с веб-сайта Flipkart

- Парсинг html-сайтов с помощью PHP, Ruby, Python

Где найти парсер?

Добыть утилиту для поиска и преобразования информации с сайтов можно четырьмя путями.

- Использование сил своей команды разработчиков. Когда в штате есть программисты, способные создать парсер, адаптированный под задачи компании, то искать другие варианты не стоит. Этот будет оптимальным вариантом.

- Нанять команду разработчиков со стороны, чтобы те создали утилиту по вашим требованиям. В таком случае уйдет много ресурсов на создание ТЗ и оплату работы.

- Установить готовое приложение-парсер на компьютер. Да, оно тоже будет стоить денег, но зато им можно воспользоваться сразу. А настройки параметров в таких программах позволяют точно настроить схему парсинга.

- Воспользоваться веб-сервисом или браузерным плагином с аналогичной функциональностью. Встречаются бесплатные версии.

При отсутствии разработчиков в штате я бы советовал именно десктопную программу. Это идеальный баланс между эффективностью и затратами. Но если задачи стоят не слишком сложные, то может хватить и облачного сервиса.

Что такое парсер и как он работает

Парсер представляет собой программу, скрипт, реализованный на одном из языков программирования (скажем, Python). Скрипт этот «тянет» данные с сайтов по нужным нам условиям.

Алгоритм работы парсера такой:

- Получаем исходный код страницы (правый щелчок по интересующему элементу нам в помощь), и оправляем в парсер на обработку.

- Проходясь по html-коду, как по обычному тексту, парсер отыскивает в нем определенные соответствия.

- Программа сравнивает, сопоставляет и отбирает массивы данных, которые нам интересны.

Как итог, парсер сохраняет результат в удобном пользователю формате. Это может быть файл SQL, XML, банальный TXT, но чаще – XLS (таблица Excel). Проще говоря, парсер бродит по указанным ему ссылкам, собирая оттуда интересную нам информацию в файл.

«Как защититься (от парсинга) по уму? Да никак, всё равно пролезем»

- Выдачу Яндекса парсить, как это делают множество SEO-сервисов. «На это спроса побольше, больше денег. Правда, они, в основном, продают целую систему аналитики SEO.» Но мы не парсим выдачу — не просили, да и там через запросов 100 сразу будет капча, нужны чистые прокси, а их сложно достать или дорогие, не так и выгодно… Само собой, больших игроков провести далеко не так просто, и читатели с нами этим делятся (мы сами НЕ парсим ГУГЛ и Яндекс). По опыту, у Яндекса, Гугла и подобных крупных корпораций существует некоторая база с подсетями датацентров (базы прокси у них ведь, обновляются, и крупные игроки на них подписаны и банят). Таким образом, поднятая сеть прокси на ip-адресах, выданных датацентрам, на отлично улетает в бан с выдачей капчи и другими причудами. По итогу остаются только незаконные варианты с закупом прокси у владельцев ботнетов и подобная «грязь», в этом случае у тебя будет реальный пользовательский ip. И даже при этом таким корпорациям очень нужно, чтобы у тебя были «отстоявшиеся» куки, с которыми ты уже «поползал» какое-то время по сайтам, где они могут тебя трекать (к примеру, счётчики посещений). Но как они вообще отличают парсеров от NAT-ов в спальных районах? Условные 100 запросов это ведь всего ничего.

- Защита от парсинга: убрав из рассмотрения «великих и ужасных», сосредоточимся на нас, «простых смертных». Если есть те, кто занимается парсингом, обязательно должны быть и те, кто будет стараться им в этом помешать. Играть интереснее с живыми людьми: появляется элемент соперничества, каждая сторона старается перехитрить другую. И, так как собирать информацию вручную никто по-прежнему не намерен, играют они в то, кто сделает бота наиболее похожего на живого человека, и кто сможет эффективнее этих ботов распознавать, продолжая при этом отвечать на запросы реальных пользователей — сайт же призван бизнесу помогать, отталкиваемся мы от этого. И, оставаясь в рамках задачи о бизнес-эффективности, нельзя не учитывать разумное распределение ресурсов и рентабельность мероприятий по, собственно, парсингу и противодействии ему:

- Защититься от парсинга нельзя (кроме как от «студентов»), но можно повысить порог затрат на него (и временных и денежных). В итоге, те данные, которые мы защищаем (несколько разделов сайта), проще не парсить, а пойти и купить готовую БД, также как покупаем ее мы. В сети валяются таблицы ip адресов парсеров, показывать этому списку капчу при входе — не проблема. Аналогично и генерить id и классы, как делает тот же mail.ru — тоже не проблема и не требует каких-то больших затрат. Новая капча от гугла вообще очень точно определяет, робот или нет. Если есть подозрения, выпилить пользователя и попросить ввести капчу — просто. В конце концов, приманку-HoneyPot для отлова бота никто не отменял. Ну и классика, заменять буквы в тексте, делать маски и тд.

- И тут мы возразим сами себе: возможно, по отдельности это всё не поможет, но все вместе осложнит вам жизнь настолько, что станет нецелесообразным. При этом все эти техники вообще не требуют больших затрат. Правда, все эти техники прекрасно обходятся, так что по сути — защиты нет. Динамические прокси, сервисы распознающие капчи индусами, и selenium с хорошо прописанным алгоритмом действий. Всё, чего можно добиться — разработка парсера будет стоить подороже, возможно кого-то это и отпугнет, но если целевой сайт — это не каталог на полторы страницы местного офиса «Рога и Копыта», то повышение затрат мало кого отпугивает.

- При защите всегда речь про использование типовых поведенческих моделей реальных посетителей, плюс систем, адекватно идентифицирующей «белых» ботов (яндекс, гугл и тп). А чтобы подстроиться под реального посетителя, нужно знать набор типовых карт переходов. И тогда простым пулом прокси при парсинге тут не обойдешься. Система не на 100% защищает, но поставленную задачу решает — по статистике просмотра можно понять, когда весь сайт отсканили. Так делают либо парсеры, либо поисковые системы. Но поисковые системы реагируют на robots.txt, а парсеры нет.

Выбираем модель

- Скорость работы. Наш парсер должен работать достаточно быстро. Синтаксис, разумеется, далеко не единственный модуль «под капотом» real-time системы, поэтому тратить на него больше десятка миллисекунд не стоит.

- Качество работы. Как минимум, самого парсера именно на данных русского языка. Требование очевидное. Для русского языка у нас есть достаточно хорошие морфологические анализаторы, которые могут встроиться в нашу пирамиду. Если мы сможем убедиться, что сам парсер без морфологии круто работает, то это нас устроит — морфологию подсунем потом.

- Наличие кода обучения и желательно модели в открытом доступе. При наличии кода обучения мы будем способны повторить результаты автора модели. Для этого они должны быть открыты. И, кроме того, нужно внимательно следить за условиями распространения корпусов и модели — придется ли нам, если мы будем их использовать в рамках своих алгоритмов, покупать лицензию на их использование?

- Запуск без сверхусилий. Этот пункт очень субъективный, но важный. Что это значит? Это значит, что если мы три дня сидим и что-то запускаем, а оно не запускается, то выбрать этот парсер мы не сможем, даже если там будет идеальное качество.

Parsing

Данный механизм действует по заданной программе и сопоставляет определенный набор слов, с тем, что нашлось в интернете. Как поступать с полученной информацией, написано в командной строке, называемой «регулярное выражение». Она состоит из символов и задает правило поиска.

Фактически понятие переводится с английского языка как семантический анализ или разбор. Но термин, применяемый в технологиях создания и наполнения вебсайта, имеет более широкое значение. Это процедура, действие, предполагающее многостороннее исследование страницы, документа, целого раздела на предмет нахождения лексических, грамматических единиц или иных элементов (не только текста, но и видео-, аудио-контента) с последующей систематизацией. Искомые сведения находятся и преобразуются, они подготавливаются для дальнейшей работы с ними. Еще можно сказать, что это быстрая оценка и скорая обработка интернет-ресурса, данных с него. Вручную подобный процесс занял бы много времени, но автоматизация его значительно упрощает.

Больше видео на нашем канале — изучайте интернет-маркетинг с SEMANTICA

Второе название для процедуры – скраппинг, или скрейпинг от англоязычного «scraping». В ходе этого буквального «соскабливания» программное обеспечение заходит на вебсайт под видом обыкновенного пользователя и, используя скрипты, производит сбор данных.

Исходником может быть ваш собственный веб-ресурс (для аналитики и принятия последующих решений), сайт конкурента, страничка из социальных сетей и пр. Полученным результатом можно будет пользоваться в дальнейшем по усмотрению владельца. Приведем понятный пример. По такому принципу работают поисковые системы, когда они анализируют страницы на релевантность, наличие ключевых слов из запроса и соответствие тематике, а затем на основе полученных сведений автоматически формируется выдача.

Достоинства парсинга

Приложения с функцией парсинга оснащены положительными сторонами, которые делают ресурс более прибыльным:

- программы для парсинга могут осуществить молниеносный мониторинг десятков тысяч станиц на страницах Интернета;

- умная программа разложит по полочкам – разделит нужные данные и техническую информацию;

- программы используют метод выборки по настроенным параметрам – останется только нужная информация;

- осуществляется выгрузка информации в удобном формате и виде.

Разновидность форматов

Разумеется, после выгрузки данных необходимо проработать их и перепроверить. Это легче, чем заниматься сутками ручным поиском необходимой информации

Самое важное – экономия энергии и времени

Определение синтаксического парсинга

Фактическое определение «синтаксического парсинга» в Викисловаре: «Разделить файл или другие входные данные на части, которые можно легко сохранить или ими манипулировать». Таким образом, мы разделяем строку на части, а затем распознаем части, чтобы преобразовать их в нечто более простое, чем строка.

Разбор целого числа

Примером может служить функция parseInt(). Для этого потребуется такой ввод, как «123», который будет строкой, состоящей из значений символов 1, 2 и 3. Затем он преобразует это значение в целое число 123, которое является простым числом, которое можно сохранить и обработать как целое число.

Мы можем понять, почему вы можете быть озадачены этим простым примером, хотя, поскольку строка «123» не имеет очевидных частей.

Разбор даты

Вот лучший пример, включающий парсинг даты из строки:

SimpleDateFormat format = new SimpleDateFormat("yyyy-MM-dd");

Date date = format.parse("2016-04-23");

В этом примере показан формат даты, который на самом деле имеет узнаваемые части:

- yyyy – год

- – это буквальная тире

- mm – месяц

- – это еще одна буквальная тире

- dd – день

Java анализирует строку даты для вас, разбивая ее на предопределенный шаблон частей и распознавая детали. Затем функция parse выводит объект даты, который легче хранить и манипулировать, чем строка даты.

Разбор целого языка

Это то, что всегда означает синтаксический анализ или парсинг (Если вам сложно осуществить парсинг самому, существуют организации предоставляющие услуги парсинга данных). Все языки программирования анализируются в соответствии с тем, как части создаются вместе в определении языка.

И не только это, но и отдельные высказывания, слова и фрагменты данных языка также могут быть проанализированы, потому что они определены как маленькие биты синтаксиса.

Примерами этого могут быть:

- Разбор шестнадцатеричного числа, например «0xFF», разбивая его на 0, x и ряд символов от 0 до 9 и af или AF.

- Разбор чисел с плавающей запятой, таких как «-1.23f», разбив его на знак, целочисленную часть, десятичную точку, дробную часть, затем букву f для float.

Небольшие структуры, подобные этому, определены на всем языке, поэтому появляются эти функции разбора. Нет никаких ограничений для функций этого типа, которые могут быть созданы, поскольку для синтаксического анализа может быть создано бесконечное множество новых синтаксических определений.

Однако Java имеет тенденцию ограничиваться вариациями известного синтаксиса, такими как integer, float и date, которые предопределены для него.

Используйте другие возможности сервисов парсинга

Сервисы для парсинга социальных сетей – универсальные инструменты. Конкретные действия, которые вы можете предпринять, зависят от вашего бизнеса.

Например, конкурент часто проводит во ВКонтакте прямые трансляции, где собирается немало людей, которым интересен продукт или услуга. Вы можете собрать ID пользователей, которые смотрят трансляцию в данный момент, и периодически обновлять данные. Так вы узнаете на самом деле заинтересованных людей и сможете сделать им лучшее предложение в таргетированной рекламе.

Вот еще несколько вариантов парсинга соцсетей с пользой для самого разного бизнеса. Например, можно:

- Привести людей на концерт. Парсинг ВК поможет найти любителей определенной музыки по их плейлистам. Поиск можно настроить на исполнителя, название трека, количество композиций в коллекции пользователя, местоположению.

- Привести клиентов в небольшую парикмахерскую. Парсинг тематических сообществ в нужном городе покажет активных пользователей за последний месяц. Найдет тех, кто поставил лайк или прокомментировал пост. Отсев неактивных участников поможет сэкономить уйму денег в рекламной кампании.

- Привести клиентов бизнесу с товарами для детей. Например, продаете школьные принадлежности, детскую обувь или игрушки. Парсинг в Инстаграме соберет базу мам, у которых есть дети подходящего возраста.

- Привести клиентов кондитерам, которые делают торты на заказ. И не только торты. Пригодится всем, кто продает гаджеты, букеты, ювелирку – все, что можно подарить. Парсинг найдет пользователей, у которых родственники отмечают день рождения в ближайшие 60 дней.

Боюсь представить, что пришлось бы этим заниматься самостоятельно. Листать страницу за страницей в соцсетях, анализировать контекст каждого слова, сравнивать десятки тысяч пользователей, фильтровать информацию и перемещать все это в удобный для чтения формат.

Проще, быстрее и полезнее для морального здоровья пользоваться сервисами парсинга.

Начнём с простого

Первым делом попробуем успешно разобрать простейшие выражения, вроде переменных и префиксных операторов с их операндами.

Основной метод парсера выражений, , может выглядеть так:

При такой структуре кода мы рискуем получить спагетти-код когда реализуем все нужные конструкции языка.

Если бы мы могли более декларативно описать отношения токенов и методов их обработки, код стал бы более наглядным. Сделать это можно, поместив методы-обработчики, типа , в или прочую структуру, которая позволяет получить метод для обработки по токену. Для большей производительности стоит использовать массивы, поскольку часто разнообразие токенов не очень велико, но для простоты реализации мы возьмём .

Поскольку у всех наших методов одинаковая сигнатура, заведём для них тип :

В сам парсер нужно добавить . При создании парсера мы инициализируем эту таблицу:

Мы ввели вспомогательную функцию для упрощения добавления префиксных операторов. Можно пойти ещё дальше, тогда инициализирующий код будет ещё больше похож на грамматику (см. заключительные главы статьи).

Автоматически следовать редиректам с cURL

Вы можете дать указание cURL следовать редиректам, т.е. открывать страницу, на которую делает редирект (перенаправление) та страница, которую мы в данный момент пытаемся открыть.

Например, если я попытаюсь открыть сайт следующим образом (обратите внимание на HTTP вместо HTTPS):

curl http://hackware.ru/

То я получу:

<!DOCTYPE HTML PUBLIC "-//IETF//DTD HTML 2.0//EN"> <html><head> <title>302 Found</title> </head><body> <h1>Found</h1> <p>The document has moved <a href="https://hackware.ru/">here</a>.</p> </body></html>

Чтобы curl переходила по перенаправлением используется опция -L:

curl -L http://hackware.ru/

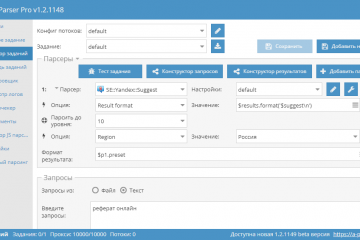

Парсеры поисковых систем#

| Название парсера | Описание |

|---|---|

| SE::Google | Парсинг всех данных с поисковой выдачи Google: ссылки, анкоры, сниппеты, Related keywords, парсинг рекламных блоков. Многопоточность, обход ReCaptcha |

| SE::Yandex | Парсинг всех данных с поисковой выдачи Yandex: ссылки, анкоры, сниппеты, Related keywords, парсинг рекламных блоков. Максимальная глубина парсинга |

| SE::AOL | Парсинг всех данных с поисковой выдачи AOL: ссылки, анкоры, сниппеты |

| SE::Bing | Парсинг всех данных с поисковой выдачи Bing: ссылки, анкоры, сниппеты, Related keywords, Максимальная глубина парсинга |

| SE::Baidu | Парсинг всех данных с поисковой выдачи Baidu: ссылки, анкоры, сниппеты, Related keywords |

| SE::Baidu | Парсинг всех данных с поисковой выдачи Baidu: ссылки, анкоры, сниппеты, Related keywords |

| SE::Dogpile | Парсинг всех данных с поисковой выдачи Dogpile: ссылки, анкоры, сниппеты, Related keywords |

| SE::DuckDuckGo | Парсинг всех данных с поисковой выдачи DuckDuckGo: ссылки, анкоры, сниппеты |

| SE::MailRu | Парсинг всех данных с поисковой выдачи MailRu: ссылки, анкоры, сниппеты |

| SE::Seznam | Парсер чешской поисковой системы seznam.cz: ссылки, анкоры, сниппеты, Related keywords |

| SE::Yahoo | Парсинг всех данных с поисковой выдачи Yahoo: ссылки, анкоры, сниппеты, Related keywords, Максимальная глубина парсинга |

| SE::Youtube | Парсинг данных с поисковой выдачи Youtube: ссылки, название, описание, имя пользователя, ссылка на превью картинки, кол-во просмотров, длина видеоролика |

| SE::Ask | Парсер американской поисковой выдачи Google через Ask.com: ссылки, анкоры, сниппеты, Related keywords |

| SE::Rambler | Парсинг всех данных с поисковой выдачи Rambler: ссылки, анкоры, сниппеты |

| SE::Startpage | Парсинг всех данных с поисковой выдачи Startpage: ссылки, анкоры, сниппеты |

Основы веб-парсинга

Веб-скраппинг состоит из двух частей: веб-сканера и веб-скребка. Проще говоря, веб-сканер – это лошадь, а скребок – колесница. Сканер ведет парсера и извлекает запрошенные данные. Давайте разберемся с этими двумя компонентами веб-парсинга:

Сканер

Поискового робота обычно называют «пауком». Это технология искусственного интеллекта, которая просматривает Интернет, индексирует и ищет контент по заданным ссылкам. Он ищет соответствующую информацию, запрошенную программистом.

Веб-скрапер – это специальный инструмент, предназначенный для быстрого и эффективного извлечения данных с нескольких веб-сайтов. Веб-скраперы сильно различаются по дизайну и сложности в зависимости от проекта.

Как работает Web Scrapping?

Давайте разберем по шагам, как работает парсинг веб-страниц.

Шаг 1. Найдите URL, который вам нужен.

Во-первых, вы должны понимать требования к данным в соответствии с вашим проектом. Веб-страница или веб-сайт содержит большой объем информации. Вот почему отбрасывайте только актуальную информацию. Проще говоря, разработчик должен быть знаком с требованиями к данным.

Шаг – 2: Проверка страницы

Данные извлекаются в необработанном формате HTML, который необходимо тщательно анализировать и отсеивать мешающие необработанные данные. В некоторых случаях данные могут быть простыми, такими как имя и адрес, или такими же сложными, как многомерные данные о погоде и данные фондового рынка.

Шаг – 3: Напишите код

Напишите код для извлечения информации, предоставления соответствующей информации и запуска кода.

Шаг – 4: Сохраните данные в файле

Сохраните эту информацию в необходимом формате файла csv, xml, JSON.

Что такое парсинг

Узнай первым о новых статьях в нашем блоге

Парсинг — это сопоставление строки естественного языка или языка программирования с формальными правилами.

Парсинг — это инструмент работы со строковыми данными. Приведем пример, чтобы было понятно.

Представьте себя радистом на войне. Вы получаете зашифрованное сообщение. У вас есть правила дешифровки. Вы начинаете разгадывать послание согласно этому методу.Вы смотрите вначале на символ из полученного сообщения. Потом на свою таблицу с его значением. Например, цифре “1” соответствует буква “Я”. Вы сопоставляете все символы и получаете то сообщение, которое можно прочитать.

Парсинг работает точно так же. Есть некоторый шаблон сообщения, написанный на формальном языке. С ним сравнивается какая-то строка.Парсинг применяется в программировании, в аналитике. Может быть полезен в любой области, где есть возможность работы со строковыми данными.

Парсинг сайта — что это

В общем случае, парсинг строит шаблон последовательности символов. Например, может использоваться древовидная структура. Она показывает, в какой последовательности в строке встречаются символы. Может указывать на приоритет, если речь идет о математическом выражении.Такие структуры нужны для анализа данных.

Парсить можно и интернет-ресурсы. Это делают, когда нужно понять, какой контент содержится на странице.Найти на страницах сайта только ту информацию, которая нужна вам для анализа — это задача парсинга.

Программа в одном файле может собрать информацию.

Например, название, цену на товар, категорию и описание. Далее вы уже сможете проанализировать это. Например, решить, какую цену установить для своего ассортимента.А может, вам нужно поработать с отзывами клиентов? Это тоже задачка для парсинга сайта — собираете нужную информацию в одном месте и читаете, что о вашем конкуренте пишут клиенты.

Этапы парсинга данных

- Сбор контента.Обычно в программу для парсинга загружается код страницы сайта. И с ним уже работает специальный скрипт — разбивает весь код на лексемы, анализирует, какая информация нужна пользователю.

- Извлечение информации.Пользователю не нужна вся информация со страницы. Вернемся к примеру выше. Нас интересуют только отзывы клиентов под конкретными товарами — например, кормом для кошек. Парсер будет находить в коде страницы то место, где указана категория товара: “Корм для кошек”. Далее он определит то место на странице, где размещены комментарии. И извлечет в конечный файл только тексты комментариев.

- Сохранение результатов.Когда вся нужная информация извлечена с сайтов, нужно ее сохранить. Обычно такие данные оформляют в виде таблиц, чтобы было наглядное представление. Можно вносить записи в базу данных. Как будет удобнее аналитику.

- Защита сайта от парсинга Любой владелец сайта хочет защитить свой контент. Кража любой информации — плохо. Ваш контент может появиться на другом ресурсе, ваша статья может перестать считаться уникальной.Мы расскажем о нескольких методах, как можно предотвратить кражу контента с вашего ресурса.

- Разграничение прав доступа.Это самый простой метод. Вы можете скрыть информацию о структуре сайта. Сделать так, чтобы она была доступна только администраторам.

- Установка временной задержки между запросами.Этот метод хорошо работает, когда на сервер направляются хаотические интенсивные запросы. Они идут от одной машины с разными промежутками. Вы можете установить временную задержку между запросами, поступающими от одной машины.

- Создание черного и белого списка.Это списки пользователей. В белом находятся добропорядочные пользователи. Черный список для тех людей, которые нарушили правила поведения сайта, пытались украсть контент и т. д.

- Установка периода обновления страниц.Чтобы снизить эффективность парсинга, установите время обновления страниц в файле sitemap.xml. Вы можете ограничить частоту запросов, объем загружаемых данных.

- Использование методов защиты от роботов.Сюда относится капча, подтверждение регистрации на ресурсе. То, что сможет выполнить человек, но не сможет проделать машина.

Парсинг может использоваться как во благо, так и во вред. Этот метод помогает проанализировать большие объемы текстовой информации. Но в то же время, проанализировать могут вас, украсть контент, вытащить конфиденциальную информацию, которая не должна попасть в чужие руки.

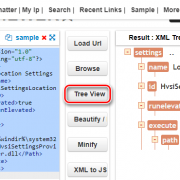

Отрендерите JS через Headless Browsers

Если XHR запросы требуют актуальных tokens, sessions, cookies. Если вы нарываетесь на защиту Cloudflare. Если вам обязательно нужно логиниться на сайте. Если вы просто решили рендерить все, что движется загружается, чтобы минимизировать вероятность бана. Во всех случаях — добро пожаловать в мир автоматизации браузеров!

Если коротко, то есть инструменты, которые позволяют управлять браузером: открывать страницы, вводить текст, скроллить, кликать. Конечно же, это все было сделано для того, чтобы автоматизировать тесты веб интерфейса. I’m something of a web QA myself.

После того, как вы открыли страницу, чуть подождали (пока JS сделает все свои 100500 запросов), можно смотреть на HTML страницу опять и поискать там тот заветный JSON со всеми данными.

Selenoid — open-source remote Selenium cluster

Для масштабируемости и простоты, я советую использовать удалённые браузерные кластеры (remote Selenium grid).

Недавно я нашел офигенный опенсорсный микросервис Selenoid, который по факту позволяет вам запускать браузеры не у себя на компе, а на удаленном сервере, подключаясь к нему по API. Несмотря на то, что Support team у них состоит из токсичных разработчиков, их микросервис довольно просто развернуть (советую это делать под VPN, так как по умолчанию никакой authentication в сервис не встроено). Я запускаю их сервис через DigitalOcean 1-Click apps: 1 клик — и у вас уже создался сервер, на котором настроен и запущен кластер Headless браузеров, готовых запускать джаваскрипт!

Вот так я подключаюсь к Selenoid из своего кода: по факту нужно просто указать адрес запущенного Selenoid, но я еще зачем-то передаю кучу параметров бразеру, вдруг вы тоже захотите. На выходе этой функции у меня обычный Selenium driver, который я использую также, как если бы я запускал браузер локально (через файлик chromedriver).

Заметьте фложок . Верно, вы сможете смотреть видосик с тем, что происходит на удалённом браузере. Всегда приятно наблюдать, как ваш скрипт самостоятельно логинится в Linkedin: он такой молодой, но уже хочет познакомиться с крутыми разработчиками.

Программа: извлечение данных с веб-сайта Flipkart

В этом примере мы удалим цены, рейтинги и название модели мобильных телефонов из Flipkart, одного из популярных веб-сайтов электронной коммерции. Ниже приведены предварительные условия для выполнения этой задачи:

- Python 2.x или Python 3.x с установленными библиотеками Selenium, BeautifulSoup, Pandas.

- Google – браузер Chrome.

- Веб-парсеры, такие как html.parser, xlml и т. д.

Шаг – 1: найдите нужный URL.

Первым шагом является поиск URL-адреса, который вы хотите удалить. Здесь мы извлекаем детали мобильного телефона из Flipkart. URL-адрес этой страницы: https://www.flipkart.com/search?q=iphones&otracker=search&otracker1=search&marketplace=FLIPKART&as-show=on&as=off.

Шаг 2: проверка страницы.

Необходимо внимательно изучить страницу, поскольку данные обычно содержатся в тегах. Итак, нам нужно провести осмотр, чтобы выбрать нужный тег. Чтобы проверить страницу, щелкните элемент правой кнопкой мыши и выберите «Проверить».

Шаг – 3: найдите данные для извлечения.

Извлеките цену, имя и рейтинг, которые содержатся в теге «div» соответственно.

Шаг – 4: напишите код.

from bs4 import BeautifulSoupas soup

from urllib.request import urlopen as uReq

# Request from the webpage

myurl = "https://www.flipkart.com/search?q=iphones&otracker=search&otracker1=search&marketplace=FLIPKART&as-show=on&as=off"

uClient = uReq(myurl)

page_html = uClient.read()

uClient.close()

page_soup = soup(page_html, features="html.parser")

# print(soup.prettify(containers))

# This variable held all html of webpage

containers = page_soup.find_all("div",{"class": "_3O0U0u"})

# container = containers

# # print(soup.prettify(container))

#

# price = container.find_all("div",{"class": "col col-5-12 _2o7WAb"})

# print(price.text)

#

# ratings = container.find_all("div",{"class": "niH0FQ"})

# print(ratings.text)

#

# #

# # print(len(containers))

# print(container.div.img)

# Creating CSV File that will store all data

filename = "product1.csv"

f = open(filename,"w")

headers = "Product_Name,Pricing,Ratings\n"

f.write(headers)

for container in containers:

product_name = container.div.img

price_container = container.find_all("div", {"class": "col col-5-12 _2o7WAb"})

price = price_container.text.strip()

rating_container = container.find_all("div",{"class":"niH0FQ"})

ratings = rating_container.text

# print("product_name:"+product_name)

# print("price:"+price)

# print("ratings:"+ str(ratings))

edit_price = ''.join(price.split(','))

sym_rupee = edit_price.split("?")

add_rs_price = "Rs"+sym_rupee

split_price = add_rs_price.split("E")

final_price = split_price

split_rating = str(ratings).split(" ")

final_rating = split_rating

print(product_name.replace(",", "|")+","+final_price+","+final_rating+"\n")

f.write(product_name.replace(",", "|")+","+final_price+","+final_rating+"\n")

f.close()

Выход:

Мы удалили детали iPhone и сохранили их в файле CSV, как вы можете видеть на выходе. В приведенном выше коде мы добавили комментарий к нескольким строкам кода для тестирования. Вы можете удалить эти комментарии и посмотреть результат.

Изучаю Python вместе с вами, читаю, собираю и записываю информацию опытных программистов.

Парсинг html-сайтов с помощью PHP, Ruby, Python

В общем смысле, парсинг – это линейное сопоставление последовательности слов с правилами языка. Понятие «язык» рассматривается в самом широком контексте. Это может быть человеческий язык (например, русский), используемый для коммуникации людей. А может и формализированный язык, в частности, любой язык программирования.

Парсинг сайтов – последовательный синтаксический анализ информации, размещённой на интернет-страницах.

Что представляет из себя текст интернет-страниц? Иерархичный набор данных, структурированный с помощью человеческих и компьютерных языков.

Макросы VBA. Пора использовать Excel правильно!

Зачем нужен парсинг?

Создавая веб-сайт, его владелец неизбежно сталкивается с проблемой – где брать контент? Оптимальный вариант: найти информацию там где её очень много – в Интернете. Но при этом приходится решать такие задачи:

- Большие объёмы. В эпоху бурного роста Сети и жесточайшей конкуренции уже всем ясно, что успешный веб-проект немыслим без размещения большого количества информации на сайте. Современные темпы жизни приводят к тому, что контента должно быть не просто много, а очень много, в количествах, намного превышающих пределы, возможные при ручном заполнении.

- Частое обновление. Обслуживание огромного потока динамично меняющейся информации не в силах обеспечить один человек или даже слаженная команда операторов. Порой информация изменяется ежеминутно и в ручном режиме обновлять её вряд ли целесообразно.

Конвертация CSV в YML. Прайс для Яндекса в нужном формате.

Парсинг сайтов является эффективным решением для автоматизации сбора и изменения информации.

По сравнению с человеком, компьютерная программа-парсер:

- быстро обойдёт тысячи веб-страниц;

- аккуратно отделит техническую информацию от «человеческой»;

- безошибочно отберёт нужное и отбросит лишнее;

- эффективно упакует конечные данные в необходимом виде.

Результат (будь то база данных или электронная таблица), конечно же, нуждается в дальнейшей обработке. Впрочем, последующие манипуляции с собранной информацией уже к теме парсинга не относятся.

Какие языки программирования используются для написания парсеров?

Любые, на которых создаются программы для работы со Всемирной Паутиной. Веб-приложения для парсинга обычно пишут на C++, Delphi, Perl, Ruby, Python, PHP.

Данный сайт создавался для того, чтобы продемонстрировать методы парсинга на самых популярных языках веб-программирования – PHP, Ruby и Python.