Пошаговая инструкция по удалению рекламного вируса “wayback machine” из браузеров chrome, firefox, ie, edge

Содержание:

- r-tools.org

- И все же автоматика лучше!

- Немного об «Архиве интернета»

- Origins, growth and storage

- FAQ

- Как проверять полученные статьи на уникальность

- Which Sites Are Cataloged?

- Why Should I Use the Wayback Machine Downloader?

- Индексация веб-страниц в интернете

- История создания Internet Archive

- Archive.is

- Installing the Latest Build

- Безрадостное будущее

- Качаем сайт с web.archive.org

- web.archive.org

- Use in legal evidence

- Method 2: using FTP

r-tools.org

Первое, что бросается в глаза дизайн сайта стороват. Ребята, пора обновлять!

Плюсы:

- Подходит для парсинга сайтов у которых мало html страниц и много ресурсов другого типа. Потомучто они рассчитывают цену по html страницам

- возможность отказаться от сайта, если качество не устроило. После того как система скачала сайт, вы можете сделать предпросмотр и отказаться если качество не устроило, но только если еще не заказали генерацию архива. (Не проверял эту функцию лично, и не могу сказать на сколько хорошо реализован предпросмотр, но в теории это плюс)

- Внедрена быстрая интеграция сайта с биржей SAPE

- Интерфейс на русском языке

Минусы:

- Есть демо-доступ — это плюс, но я попробовал сделать 4 задания и не получил никакого результата.

- Высокие цены. Парсинг 25000 стр. обойдется в 2475 руб. , а например на Архивариксе 17$. Нужно учесть, что r-tools считает html страницы, архиварикс файлы. Но даже если из всех файлов за 17$ только половина html страницы, все равно у r-tools выходит дороже. (нужно оговориться, что считал при $=70руб. И возможна ситуация, когда r-tools будет выгоден написал про это в плюсах)

И все же автоматика лучше!

Если ручной метод — не для вас, и хочется более легкий путь, существует множество специализированного ПО, которое сделает всю работу за вас. Я рекомендую воспользоваться UnHackMe от Greatis Software, выполнив все по пошаговой инструкции.

UnHackMe выполнит все указанные шаги, проверяя по своей базе, всего за одну минуту.

При этом UnHackMe скорее всего найдет и другие вредоносные программы, а не только редиректор на WAYBACK MACHINE.

При ручном удалении могут возникнуть проблемы с удалением открытых файлов. Закрываемые процессы могут немедленно запускаться вновь, либо могут сделать это после перезагрузки. Часто возникают ситуации, когда недостаточно прав для удалении ключа реестра или файла.

UnHackMe легко со всем справится и выполнит всю трудную работу во время перезагрузки.

И это еще не все. Если после удаления редиректа на WAYBACK MACHINE какие то проблемы остались, то в UnHackMe есть ручной режим, в котором можно самостоятельно определять вредоносные программы в списке всех программ.

Немного об «Архиве интернета»

Оригинальный американский сервис Wayback Machine позволяет пользователям «оживить» старые версии нужных им сайтов. За 25 лет существования организация «Архив интернета» сохранила 617 млрд веб-страниц. Пользователю достаточно вписать адрес искомого сайта и выбрать временной промежуток, который его интересует.

От DevOps к TestOps: как ускорить процессы тестирования новых приложений и ПО

Интеграция

В настоящее время интернет-архив – это ресурс мирового масштаба. Он официально входит в Международный консорциум сохранения интернета (International Internet Preservation Consortium).

В архиве есть не только сайты, но и старые видеоигры и программы. К примеру, в конце января был закрыт портал Портал Tucows Downloads – старейший в мире сайт с залежами компьютерных программ и игрушек. Он был основан в 1993 г. и в последние годы не пользовался популярностью.

Как сообщал CNews, создатели сайта передали архив с программами, загруженными в Tucows Downloads в период с 1993 по 2004 гг. (более 32 тыс. файлов), организации «Архив интернета». Она заверила, что позаботится о сохранности этого наследия.

В ноябре 2020 г. «Архив интернета» пообещала сохранить популярный flash-контент, который она считает культурным достоянием человечества, в собственной коллекции. Связано это с полным прекращением поддержки технологии Flash 31 декабря 2020 г., а с 12 января 2021 г. в Сети ведется глобальная блокировка flash-контента.

Origins, growth and storage

In 1996, Brewster Kahle, with Bruce Gilliat, developed software to crawl and download all publicly accessible World Wide Web pages, the Gopher hierarchy, the Netnews bulletin board system, and downloadable software. The information collected by these «crawlers» does not collect all the information available on the Internet since much of the data is restricted by the publisher or stored in databases that are not accessible. These «crawlers» also respect the robots exclusion standard for websites wishing to opt-out of appearing in search results or being cached. To overcome inconsistencies in partially cached websites, Archive-It.org was developed in 2005 by the Internet Archive as a means of allowing institutions and content creators to voluntarily harvest and preserve collections of digital content, and create digital archives.

The digital library grew and grew and grew. But a lot of people knew about it. Information was kept on digital tape for five years, with Kahle occasionally allowing researchers and scientists to tap into the clunky database. When the archive reached its five-year anniversary, it was unveiled and opened to the public in a ceremony at the University of California-Berkeley.

Snapshots usually become available more than 6 months after they are archived, or in some cases, even later, 24 months or longer. The frequency of snapshots is variable, so not all tracked web site updates are recorded. Intervals of several weeks or years sometimes occur.

After August 2008 sites had to be listed on the Open Directory in order to be included. According to Jeff Kaplan of the Internet Archive in November 2010, other sites were still being archived, but more recent captures would only become visible after the next major indexing, an infrequent operation.

As of 2009 the Wayback Machine contained approximately three petabytes of data and was growing at a rate of 100 terabytes each month; the growth rate reported in 2003 was 12 terabytes/month. The data is stored on PetaBox rack systems manufactured by Capricorn Technologies.

In 2009 the Internet Archive migrated its customized storage architecture to Sun Open Storage, and hosts a new datacenter in a Sun Modular Datacenter on Sun Microsystems’ California campus.

In 2011 a new, improved version of the Wayback Machine, with an updated interface and fresher index of archived content, was made available for public testing.

In March 2011 it was said on the Wayback Machine forum that «The Beta of the new Wayback Machine has a more complete and up-to-date index of all crawled materials into 2010, and will continue to be updated regularly. The index driving the classic Wayback Machine only has a little bit of material past 2008, and no further index updates are planned, as it will be phased out this year.»

FAQ

I download from Wayback Machine but can use only a home page of the site, why?

The site you download from Wayback Machine needs to be installed on the server. You can’t just view all its pages on your PC. Also, make sure you’ve installed thefile called .htaccess on the server – it is responsible for the correctness of URLs working. Mind that it is compatible with Apache servers only. Finally, checkwhether you used a demo or paid archive.org Downloader. The demo version has a limit of 4 pages.

Why does Wayback Machine Downloader work slowly?

Sometimes, when you download Wayback Machine sites, you have to wait for several hours until the process is completed, especially is the site is large. This is primarily the fault of the Web Archive itself rather than the archive.org Downloader. The Archive is slow; moreover, it can block IPs, which try to downloadWayback Machine files too fast. The speed can further drop down if the original site contains many broken links.

Don’t I break the copyright laws by using the Wayback Machine Downloader?

If you use the archive.org Downloader to restore your own site, then, obviously, you don’t violate any laws, and the content belongs to you. When it comes to accessing third-party sites by using Wayback downloads, the legislative norms can vary from one country to another. But anyway, the risk is minimal, as few peoplecare much about their former websites. Thus, there are no recorded cases of complaints about using third-party expired content.

How long should I wait for the delivery of a WordPress conversion?

The conversion itself usually takes no more than 1-2 business days. But you need to keep in mind that depending on the Wayback Machine download site size, thedownload process can take from several hours to several days.

Will the Downloader tool archive entire website or a single page that I specify?

The Wayback Machine Downloader always extracts entire sites (up to 20 thousand pages per domain.) All the pages that can be accessed from the starting page willbe automatically downloaded.

What is the total number of files the Wayback Machine Downloader can extract?

The Wayback Machine Downloader will try to get all files that are found on the domain. But sometimes, attempts fail if the Web Archive declines the requests. Commonly, the webarchive extractor makes up to five attempts using different IP-addresses.

If you have additional questions of how to download from archive.org effectively and correctly, read the full review on the official site of the download WaybackMachine tool. It contains detailed guides and instructions on archive downloading, extracting, installing, and using.

Как проверять полученные статьи на уникальность

Есть несколько способов проверки статей на уникальность и наверное многие из них вам известны. Тем не мене здесь мы приведем лучшие способы проверки контента на уникальность.

- Проверка статей с использованием специализированных сервисов типа etxt.ru, text.ru или адвего. Данный способ подходит когда нужно проверить одну или две статьи, так как проверка занимает длительное время и существуют ограничения по количеству проверок в день с конкретного IP адреса.

- Если вам не жалко немного денег, то для ускорения процесса можно использовать пакетную проверку статей предоставляемую такими сервисами.

- Использовать специализированное программное обеспечение для проверки уникальности статей типа Advego Plagiatus.

Программа для проверки уникальности статей из Вебархива

После чего открываем программу и загружаем наши статьи для пакетной проверки используйте меню программы: «Операции -> Пакетная проверка».

Настройка программы для проверки уникальных статей из вебархива

Если у вас отсутствует необходимость проверять много статей, то просто включите отображение каптчи и вводите ее вручную.

На этом пожалуй все. Мы рассмотрели как можно получить множество уникальных статей абсолютно бесплатно. Желаем вам удачи !

Ссылки используемые в статье

- 1. web.archive.org – интернет архив веб сайтов

- 2. Web Arhcive Downloder – это уникальная программа для сохранения сайтов из интернет архива.

Which Sites Are Cataloged?

Many popular websites are automatically archived by the Wayback Machine. However, you can use the Wayback Machine to manually archive virtually any page. Websites are often abandoned or changed completely, so the Wayback machine acts as a way to preserve the culture of the Internet by keeping a digital “hard copy” of a website. Be aware that text and images are left intact; however, some outbound links and embedded items (e.g. videos) are not.

It is important to note that The Wayback Machine only scans and archives public sites. This means that password protected sites or ones located on private servers cannot be archived. In addition, if a website prohibits search engines from including it in search results, Wayback Machine will not be able to archive it.

Why Should I Use the Wayback Machine Downloader?

People may need to download Wayback Machine archive sites for various reasons. Here are just some of them.

- With the help of website archive download, you can get content that used to be posted on the competitors’ sites until they went off the stage.

- You can restore website from Wayback Machine if you have lost it for some reason. For example, due to temporary financial troubles, you can miss the hostingpayment(s) and lose the card used in your hosting account. In this case, you can download site from Wayback Machine and transfer it to a new hosting.

- You suffered from a hacker attack. Even if all the content was deleted or replaced with something, it’s not the end of life. Just download website fromWayback Machine and restore its previous working version.

- Legal issues. You may need to use the data from your old site as evidence of something. The Wayback Downloader will help you get access to the copy of thewebsite as of the needed date.

- With the web archive Downloader, you can get access to expired content and use it for building a new PBN network.

There are other reasons why you may need a website archive download. Whatever your final goal is, Wayback Machine Downloader will help to do it easily and withminimum hassle.

Индексация веб-страниц в интернете

Начиная с 1996 года по настоящее время на сайте archive.org собрано более 466 миллиардов веб-страниц (эта цифра все время увеличивается). Архив страниц интернета создан для сохранения, ознакомления и изучения имеющей информации, которая накопилась за все эти годы во всемирной сети.

Время от времени, специальные роботы, принадлежащие сервису, индексируют содержание практически всех сайтов в интернете

Следует принять во внимание, что во время обхода робота для индексации сайтов, на некоторых сайтах могли возникать внутренние проблемы: сайт, или некоторые страницы сайта были недоступны, сайт находился на техобслуживании, не работали подключаемые внешние элементы и т. д

Поэтому некоторые архивы сайтов будут полными, а некоторые снимки (архивы) могут содержать только частичную информацию. Имейте в виду, что некоторые сайты индексируются часто, другие сайты, наоборот, довольно редко.

Для просмотра веб-страниц используется онлайн сервис The Wayback Machine. В Internet Archive доступны для просмотра не только действующие в настоящий момент сайты, но и сайты, которые уже не существуют. С помощью архива интернета можно побывать на прекративших существование сайтах, и ознакомится с содержимым веб-страниц удаленных сайтов.

Благодаря замечательному архиву сайтов интернета можно проследить историю изменений, как изменялся внешний облик сайта и его содержимое с течением времени, использовать архивы для восстановления сайта, искать необходимую информацию.

На главной странице сайта archive.org можно получить доступ к архивным данным, которые сгруппированы в тематические разделы, или сразу перейти на страницу сервиса Wayback Machine.

История создания Internet Archive

В 1996 году Брюстер Кайл, американский программист, создал Архив Интернета, где он начал собирать копии веб-сайтов, со всей находящейся в них информацией. Это были полностью сохраненные в реальном виде страницы, как если бы вы открыли необходимый сайт в браузере.

Данными веб-архива может воспользоваться каждый желающий совершенно бесплатно. Создавая его, у Брюстера Кайла была основная цель – сохранить культурно-исторические ценности интернет-пространства и создать обширную электронную библиотеку.

В 2001 году был создан основной сервис Internet Archive Wayback Machine, который и сегодня можно найти по адресу https://archive.org. Именно здесь находятся копии всех веб-сервисов в свободном доступе для просмотра.

Чтобы не ограничиваться коллекцией сайтов, в 1999 году начали архивировать тексты, изображения, звукозаписи, видео и программные обеспечения.

В марте 2010 года, на ежегодной премии Free Software Awards, Архив Интернета был удостоен звания победителя в номинации Project of Social Benefit.

С каждым годом библиотека разрастается, и уже в августе 2016 года объем Webarchive составил 502 миллиарда копий веб-страниц. Все они хранятся на очень больших серверах в Сан-Франциско, Новой Александрии и Амстердаме.

Archive.is

Archive.is является еще одной хорошей альтернативой Wayback Machine и, возможно, лучше, чем скриншоты для большинства людей. Это не один из самых привлекательных веб-сайтов или простой в навигации, но его база данных и методы архивирования восполняют его.

Archive.is позволит вам выполнять поиск по истории веб-сайта и снимать скриншот любого домена по запросу, который будет сохранен для всеобщего просмотра. Это делает его идеальным решением для получения всех подробностей о веб-сайте, включая данные и графические данные.

Как это устроено

Archive.is архивирует веб-сайт по запросу или в соответствии с частотой действий на конкретном веб-сайте. Это займет и скриншот и код сайта во время архивирования. Однако, в отличие от Wayback Machine, он не отправляет сканеры для архивирования веб-страниц. Это означает, что веб-сайт не может остановить Archive.is от архивирования с использованием файла robot.txt.

Если существует веб-сайт, который может блокировать сканирование Wayback Machine своего сайта, вам следует выбрать Archive.is, чтобы получить доступ к нему.

Практическое использование

Веб-сайт Archive.is не так привлекателен, как Wayback Machine или Screenshots. Хотя, это довольно просто для навигации с наименьшим количеством вариантов для беспокойства. На главной странице вы найдете две панели поиска, одну красную сверху и другую синюю снизу. Красная панель поиска — это место, где вы можете запросить архивирование веб-страницы, а синим цветом вы можете просмотреть историю любого веб-сайта.

Архив спроса

В красной строке поиска вы можете потребовать архивирование любого веб-сайта, а Archive.is скопирует код и сделает его снимок экрана. Просто введите URL-адрес страницы веб-сайта в строку поиска и нажмите «сохранить страницу».

Archive.is начнет обработку и после небольшой задержки (в зависимости от размера страницы) вы увидите заархивированную страницу и снимок экрана с ней.

Примечание . Вы не ограничены простым добавлением URL-адреса целевой страницы определенного веб-сайта, вы можете добавить URL-адрес любой страницы веб-сайта. Просто зайдите на страницу, которую вы хотите заархивировать, и скопируйте / вставьте ее URL в архиве. При поиске он будет заархивирован.

Проверить архивную историю веб-сайта

В синей строке поиска ниже вы можете ввести URL-адрес веб-сайта, и вы увидите всю его историю. Будет два варианта: самый старый и самый новый. Самая старая содержит самую старую заархивированную веб-страницу, а самая новая содержит самые последние заархивированные страницы и возвращаясь оттуда.

Вы увидите все заархивированные страницы, начиная с самых последних и возвращаясь назад, вместе с данными, указанными под каждой веб-страницей. Вы можете просто нажать на любую веб-страницу, чтобы увидеть ее детали.

Откроется архивированная веб-страница, и вы можете легко перемещаться по ней. Вы можете нажать на «Снимок экрана», чтобы увидеть скриншот этой конкретной веб-страницы.

В наших результатах скриншоты архивировались 9gag 21 раз, а с другой стороны, Archive.is архивировал его 1063 раза. С этим небольшим примером вы можете взвесить частоту архивирования сайта.

Основные характеристики: архивирует как код, так и снимок экрана веб-страницы, огромную базу данных, обменивается результатами и загружает их, а также запрашивает архивирование любого веб-сайта в любое время.

Минусы: непривлекательный интерфейс, сложно ориентироваться на нужной веб-странице и не предоставляет много информации о конкретной веб-странице.

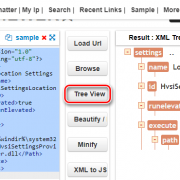

Installing the Latest Build

First tap on the Code button, Download ZIP, unzip the file in a location where you can find on your computer, then follow the steps below for your browser.

Chrome

- Open Chrome and navigate to in your browser. You can also access this page by clicking on the 3 vertical dots menu on the top-right, hovering over More Tools, then selecting Extensions.

- Turn on the switch next to Developer mode.

- Click the Load unpacked button and select the directory that contains this code.

- Click on the Extensions puzzle-like icon in the toolbar.

- Now click on the Pin icon next to Wayback Machine to pin it.

- Click on the newly added icon.

- Read the terms, then Accept and Enable. Click on the icon again to use the extension.

Firefox

- Open Firefox and navigate to in the browser. You can also access this page by clicking on the hamburger menu on the top-right, select Add-ons, then the Gear Tools button on the top-right, then Debug Add-ons.

- Click This Firefox on the left.

- Click Load Temporary Add-on…

- Open the directory and select any file.

- Click on the newly added icon in the toolbar.

- Read the terms, then Accept and Enable. Click on the icon again to use the extension.

Edge

- Open Edge and navigate to in your browser. You can also access this page by clicking on the 3 horizontal dots menu on the top-right, then clicking Extensions.

- Turn on the switch next to Developer mode.

- Click the Load unpacked button and select the directory that contains this code.

- Click on the newly added icon in the toolbar.

- Read the terms, then Accept and Enable. Click on the icon again to use the extension.

Safari 14+

This will require Xcode to compile from source.

- Open Safari.

- If Develop menu is hidden, go to Preferences > Advanced > check «Show Develop menu in menu bar».

- Then Develop menu > Allow Unsigned Extensions (enter password).

- Open the project file in Xcode. Click Play to run.

- Follow directions in splash window:

- Safari menu > Preferences > Extensions tab.

- Check to activate Wayback Machine.

- Select «Always Allow on Every Website…» button and confirm.

- Click on the newly added icon in the toolbar.

- Read the terms, then Accept and Enable. Click on the icon again to use the extension.

Безрадостное будущее

По мнению авторов Wayforward Machine, интернет будущего будет напоминать интернет 15-летней давности, когда блокировщиков спама еще толком не существовало, а сайты кишели анимированными изображениями и мельтешащей рекламой. Интернет может вернуться к такому, только вместо всплывающей рекламы будут всплывающие предупреждения о нарушении закона при посещении сайта, требования загрузить или сдать биометрию документы для подтверждения личности, а также сообщения о блокировке сайта за многочисленные «противоправные действия».

Популярные ресурсы будут запрашивать огромные деньги за пользование ими. Некоторые востребованные в настоящее время сайты попросту изживут себя и перестанут работать.

Баннеры сообщают о необходимости отключить брандмауэр и уведомляет о блокировке сайта в целях безопасности

Создатели Wayforward Machine подчеркивают, что пока все, что они придумали – это всего лишь фантазии. Тем не менее, они легко могут не только стать реальностью, но и прекратиться в часть повседневной жизни.

Авторы проекта опубликовали прогноз изменений в обществе и интернете, которые приведут к полной зарегулированности Мировой паутины для жителей всех стран. Перечень состоит из десятков пунктов, и далеко не факт, что прогнозы сбудутся только при выполнении каждого из них.

Прогнозы Архива интернета

При закрытии одного баннера на его месте тут же появляется другой. Окна, требующие взаимодействия могут зависать – например, баннер, требующий отправки сканов документов, «висит» на процессе отправки. Закрыть его при этом нельзя – «крестик» или хаотично перемещается по окошку, словно убегая от курсора или не реагирует на нажатия.

Качаем сайт с web.archive.org

Процесс восстановления сайта из веб-архива я покажу на примере сайта 1mds.ru. Я не знаю что это за сайт, я всего лишь знаю что у него в архиве много страниц, а это значит что сайт не только существовал, но с ним работали.

Для того, что бы открыть архив нужного сайта, нам необходимо пройти по такой вот ссылке:

http://web.archive.org/web/*/1mds.ru

На 24 ноября 2018 года, при открытии этой ссылки я обнаружил вот такую картину:

Как видите на главной зафиксировались результаты экспериментов с программной частью. Если мы просто скачаем сайт как есть, то в качестве главной будет именно эта страница. нам необходимо избежать попадания в архив таких страниц. Как это сделать? Довольно просто, но для начала необходимо определить когда последний раз в архив добавлялась главная страница сайта. Для этого нам необходимо воспользоваться навигацией по архиву сайта, которая расположена вверху справа:

Кликаем левую стрелку ибо правая все равно не активна, и кликаем до тех пор, пока не увидим главную страницу сайта. Возможно кликать придется много, бывает домены попадаются с весьма богатым прошлым. Например сайт, на примере которого я демонстрирую работу с архивом, не является исключением.

Вот мы можем видеть что 2 мая 2018-го бот обнаружил сообщение о том, что домен направлен на другой сайт:

Классика жанра, регистрируешь домен и направляешь его на существующий дабы не тратить лимит тарифа на количество сайтов.

А до этого, 30 марта, там был вообще блог про шитье-вязание.

Долистал я до 23 октября 2017-го и вижу уже другое содержимое:

Тут мы видим уже материалы связанные с воспитанием ребенка. Листаем дальше, там вообще попадается период когда на домене была всего одна страница с рекламой:

А вот с 25 апреля 2011 по 10 сентября 2013-го там был сайт связанный с рекламой. В общем нам нужно определиться какой из этих периодов мы хотим восстановить. К примеру я хочу восстановить блог про шитье-вязание. Мне необходимо найти дату его появления и дату когда этот блог был замечен там последний раз.

Я нашел последнюю дату, когда блог был на домене и скопировал ссылку из адресной строки:

http://web.archive.org/web/20180330034350/http://1mds.ru:80/

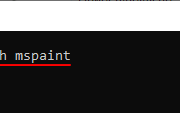

Мне нужны цифры после web/, я их выделил красным цветом. Это временная метка, когда была сделана копия. Теперь мне нужно найти первую копию блога и также скопировать из URL временную метку. Теперь у нас есть две метки с которой и до которой нам нужна копия сайта. Осталось дело за малым, установить утилиту, которая поможет нам скачать сайт. Для этого потребуется выполнить пару команд.

- sudo apt install ruby

- sudo gem install wayback_machine_downloader

После чего останется запустить скачивание сайта. Делается это вот такой командой:

wayback_machine_downloader -f20171223224600 -t20180330034350 1mds.ru

Таким образом мы скачаем архив с 23/12/2017 по 30/03/2018. Файлы сайта будут сохранены в домашней директории в папке «websites/1mds.ru». Теперь остается закинуть файлы на хостинг и радоваться результату.

web.archive.org

Этот сервис веб архива ещё известен как Wayback Machine. Имеет разные дополнительные функции, чаще всего используется инструментами по восстановлению сайтов и информации.

Для сохранения страницы в архив перейдите по адресу https://archive.org/web/ введите адрес интересующей вас страницы и нажмите кнопку «SAVE PAGE».

Для просмотра доступных сохранённых версий веб-страницы, перейдите по адресу https://archive.org/web/, введите адрес интересующей вас страницы или домен веб-сайта и нажмите «BROWSE HISTORY»:

В самом верху написано, сколько всего снимком страницы сделано, дата первого и последнего снимка.

Затем идёт шкала времени на которой можно выбрать интересующий год, при выборе года, будет обновляться календарь.

Обратите внимание, что календарь показывает не количество изменений на сайте, а количество раз, когда был сделан архив страницы.

Точки на календаре означают разные события, разные цвета несут разный смысл о веб захвате. Голубой означает, что при архивации страницы от веб-сервера был получен код ответа 2nn (всё хорошо); зелёный означает, что архиватор получил статус 3nn (перенаправление); оранжевый означает, что получен статус 4nn (ошибка на стороне клиента, например, страница не найдена), а красный означает, что при архивации получена ошибка 5nn (проблемы на сервере). Вероятно, чаще всего вас должны интересовать голубые и зелёные точки и ссылки.

При клике на выбранное время, будет открыта ссылка, например, http://web.archive.org/web/20160803222240/https://hackware.ru/ и вам будет показано, как выглядела страница в то время:

Используя эту миниатюру вы сможете переходить к следующему снимку страницы, либо перепрыгнуть к нужной дате:

Лучший способ увидеть все файлы, которые были архивированы для определённого сайта, это открыть ссылку вида http://web.archive.org/*/www.yoursite.com/*, например, http://web.archive.org/*/hackware.ru/

Кроме календаря доступна следующие страницы:

- Collections — коллекции. Доступны как дополнительные функции для зарегистрированных пользователей и по подписке

- Changes

- Summary

- Site Map

Changes

«Changes» — это инструмент, который вы можете использовать для идентификации и отображения изменений в содержимом заархивированных URL.

Начать вы можете с того, что выберите два различных дня какого-то URL. Для этого кликните на соответствующие точки:

И нажмите кнопку Compare. В результате будут показаны два варианта страницы. Жёлтый цвет показывает удалённый контент, а голубой цвет показывает добавленный контент.

В этой вкладке статистика о количестве изменений MIME-типов.

Site Map

Как следует из название, здесь показывается диаграмма карты сайта, используя которую вы можете перейти к архиву интересующей вас страницы.

Если вместо адреса страницы вы введёте что-то другое, то будет выполнен поиск по архивированным сайтам:

Показ страницы на определённую дату

Кроме использования календаря для перехода к нужной дате, вы можете просмотреть страницу на нужную дату используя ссылку следующего вида: http://web.archive.org/web/ГГГГММДДЧЧММСС/АДРЕС_СТРАНИЦЫ/

Обратите внимание, что в строке ГГГГММДДЧЧММСС можно пропустить любое количество конечных цифр.

Если на нужную дату не найдена архивная копия, то будет показана версия на ближайшую имеющуюся дату.

Use in legal evidence

Civil litigation

Netbula LLC v. Chordiant Software Inc.

In a 2009 case Netbula, LLC v. Chordiant Software Inc., defendant Chordiant filed a motion to compel Netbula to disable the robots.txt file on its web site that was causing the Wayback Machine to retroactively remove access to previous versions of pages it had archived from Nebula’s site, pages which Chordiant believed would support its case.

Netbula objected to the motion on the ground that defendants were asking to alter Netbula’s web site and that they should have subpoenaed Internet Archive for the pages directly. However, an employee of Internet Archive filed a sworn statement supporting Chordiant’s motion, stating that it could not produce the web pages by any other means «without considerable burden, expense and disruption to its operations.»

Magistrate Judge Howard Lloyd in the Northern District of California, San Jose Division, rejected Netbula’s arguments and ordered them to temporarily disable the robots.txt blockage in order to allow Chordiant to retrieve the archived pages that they sought.

Telewizja Polska

In an October 2004 case called «Telewizja Polska SA v. Echostar Satellite», a litigant attempted to use the Wayback Machine archives as a source of admissible evidence, perhaps for the first time. Telewizja Polska is the provider of TVP Polonia and EchoStar operates the Dish Network. Prior to the trial proceedings, EchoStar indicated that it intended to offer Wayback Machine snapshots as proof of the past content of Telewizja Polska’s website. Telewizja Polska brought a motion in limine to suppress the snapshots on the grounds of hearsay and unauthenticated source, but Magistrate Judge Arlander Keys rejected Telewizja Polska’s assertion of hearsay and denied TVP’s motion in limine to exclude the evidence at trial. However, at the actual trial, district Court Judge Ronald Guzman, the trial judge, overruled Magistrate Keys’ findings, and held that neither the affidavit of the Internet Archive employee nor the underlying pages (i.e., the Telewizja Polska website) were admissible as evidence. Judge Guzman reasoned that the employee’s affidavit contained both hearsay and inconclusive supporting statements, and the purported webpage printouts themselves were not self-authenticating.

Patent law

- Main article: Internet as a source of prior art

The United States patent office and, provided some additional requirements are met (e.g. providing an authoritative statement of the archivist), the European Patent Office will accept date stamps from the Internet Archive as evidence of when a given Web page was accessible to the public. These dates are used to determine if a Web page is available as prior art for instance in examining a patent application.[citation needed]

There are technical limitations to archiving a website, and as a consequence, it is possible for opposing parties in litigation to misuse the results provided by website archives. This problem can be exacerbated by the practice of submitting screen shots of web pages in complaints, answers or expert witness reports, when the underlying links are not exposed and therefore can contain errors. For example, archives like the Wayback Machine do not fill out forms and therefore do not include the contents of e-commerce databases in their archives.

Method 2: using FTP

This Tutorial explains how you can recover a website from the Waybackmachine. It also explains exactly how you can upload the files with Cpanel and FTP.

- 1. Download the .zip file with all the HTML files. Extract the files (unzip) to a folder of your choice.

- 2. You need to transfer the files to the server using FTP software. If you don’t have an FTP client already, then we recommend FileZilla: https://filezilla-project.org/

-

3. If you don’t already have an FTP account at your hosting provider, then create one. If your host uses cPanel, then find the icon that says «FTP Accounts» (most hosting providers use cPanel: Hostgator, Godaddy, BlueHost : all of them use cPanel)

cPanel example:It’s usually easier to create an FTP account when adding a domain to your hosting:

- 4. Find the IP address of your server. In GoDaddy you can find your IP address on the hosting dashboard:

-

5. We use FileZilla for Windows in this guide, but you can also download it for Apple computers.

You should now have an FTP account and know your IP address. Open an FTP client. We use FileZilla in this guide.

— Fill in your username and password.

— The username should be

— Host should be the IP address of your server, that will host the Wayback files.

— Port can be blank.

— Press Quickconnect to connect. - 6. Now select all the files and move them to the remote site:

- 7. Your site should work now.